централизованная система управления сетью

Когда говорят о централизованной системе управления сетью, многие сразу представляют себе красивую панель с картой, где всё мигает и можно одним кликом решить любую проблему. Это, пожалуй, самый распространённый и опасный миф. На деле, за этой ?красивой картинкой? скрывается чудовищный пласт интеграции, постоянных компромиссов и ситуаций, когда система вместо помощи создаёт новые точки отказа. Особенно остро это чувствуется в промышленных сегментах, где сеть — это не просто интернет в офисе, а кровеносная система производства. Вот, к примеру, наше оборудование для термического напыления — оно должно не просто передавать телеметрию, а делать это с жёсткими таймингами и в условиях сильных электромагнитных помех. И здесь любая ?централизация? спотыкается о физику цеха.

Теория против реальности: когда диаграммы не работают

В учебниках всё гладко: есть единая точка контроля, агенты на устройствах, стандартизированные протоколы. Попробуй внедри это на действующем производстве, где половина критичного оборудования выпущена лет двадцать назад и общается через самопальные интерфейсы. Мы в ООО Чжэнчжоу Лицзя Термического Напыления Оборудования через это прошли, когда пытались завести данные с наших же установок напыления в общую сетевую систему мониторинга. Задумка была здравая: видеть состояние всех машин в реальном времени из одного кабинета.

Но оказалось, что ?реальное время? для сетевой системы и для процесса напыления — это разные вещи. Система опрашивала устройства раз в 30 секунд, и этого хватало для отслеживания доступности. Однако для контроля параметров напыления — температуры факела, давления газа — нужны были данные с частотой минимум 10 раз в секунду. Центральный сервер просто захлёбывался бы трафиком, если бы со всех машин пошел такой поток. Пришлось искать гибридное решение: локальные контроллеры на цеху агрегировали данные, а в центральную систему отправляли уже усреднённые показатели и аварийные события. Это был отход от канонической централизованной системы управления, но без этого работа была бы невозможна.

Ещё один камень преткновения — безопасность. Внедряя такую систему, ты невольно создаёшь единую точку входа для атаки. Если злоумышленник получит доступ к центральному серверу, он видит ВСЁ. Поэтому при реализации проекта для нашего сайта https://www.lijiacoating.ru мы сразу заложили избыточное сегментирование. Сеть исследовательского отдела, где идут расчёты новых покрытий, физически отделена от сети производственного цеха, хотя на панели управления они отображаются вместе. Это добавляет головной боли администраторам, но сводит риски к минимуму.

Инструменты и разочарования: Zabbix, PRTG и наши доработки

Начинали, как и многие, с открытых решений вроде Zabbix. Хороший инструмент для старта, но когда дело дошло до специфичных метрик с нашего оборудования — например, степень износа сопла горелки, определяемая по косвенным сетевым задержкам в управляющих командах — пришлось писать свои шаблоны и скрипты почти с нуля. Система переставала быть ?коробочной?.

Потом был эксперимент с PRTG. Красиво, удобно, но его агентская модель на некоторых наших контроллерах вела себя нестабильно. Возникали ситуации, когда сеть в цеху в порядке, а агент ?тупил? и в центральную консоль сыпались ложные алерты о простое оборудования. Простоя не было — шла плановая выгрузка порошка. Пришлось разбираться в логике опроса и тонко настраивать таймауты. Это тот самый момент, когда понимаешь, что централизованное управление — это не про установку софта, а про глубокую адаптацию под процессы.

Самый ценный урок, пожалуй, — это важность ?немого? мониторинга. Не всё, что может отследить система, должно выводиться на главный экран и уж тем более слать оповещения. Мы наступили на эти грабли, когда после внедрения инженеры получили сотни уведомлений в день. Они быстро начали их игнорировать, и пропустили одно действительно важное — о постепенном падении давления в магистрали газа. Теперь мы жёстко фильтруем: на дашборд — только ключевые KPI, в SMS — только события, требующие реакции в течение 15 минут.

Специфика нашего контекста: исследования и производство под одной крышей

Наша компания, ООО Чжэнчжоу Лицзя Термического Напыления Оборудования, как следует из названия, занимается и исследованиями, и производством. Это создаёт уникальные требования к сети. Лаборатория генерирует огромные объёмы данных по испытаниям покрытий — их нужно оперативно передавать на вычислительные серверы, а результаты — в отдел разработки. Производственный же цех требует детерминированной сети для управления станками.

Объединить эти два мира в одной централизованной системе — задача нетривиальная. Приоритеты разные: для исследований важна пропускная способность, для цеха — стабильность и задержки. Мы пошли по пути создания виртуальных overlay-сетей поверх общей физической инфраструктуры. На уровне центрального управления это выглядит как единая сеть, но политики QoS (качества обслуживания) для каждого сегмента свои. Это позволяет, например, гарантировать, что команда на запуск плазменной горелки в цеху будет обработана в приоритете перед передачей большого файла с 3D-моделью из лаборатории.

Интеграция сайта https://www.lijiacoating.ru в эту экосистему — отдельная история. Сайт не просто визитка, это точка входа для клиентов, где есть кабинет для отслеживания статуса заказа. Информация о производственном плане и готовности изделия подтягивается как раз из нашей производственной MES-системы, которая, в свою очередь, завязана на сетевую инфраструктуру. Поломка канала связи между цехом и веб-сервером означала, что клиент видит устаревшую информацию. Пришлось продумывать схему репликации данных с кэшированием на веб-сервере, чтобы обеспечить отказоустойчивость.

Провалы, которые учат больше, чем успехи

Был у нас один печальный опыт, о котором не пишут в кейсах. Решили автоматизировать перераспределение сетевой нагрузки между цехами на основе данных от системы управления. Логика простая: если в цехе №1 простой, а в цехе №2 пиковая нагрузка, часть вычислительных задач можно перебросить. В теории. На практике триггер сработал во время планового техобслуживания в цехе №1, система решила, что там ?мало нагрузки?, и начала перенаправлять фоновые задачи с цеха №2. Это вызвало лавинообразную нагрузку на магистральные коммутаторы, которые и так были под завязку. Результат — кратковременный, но полный коллапс сети в обоих цехах.

Этот случай заставил нас кардинально пересмотреть подход к автоматизации. Теперь любое действие, инициированное централизованной системой управления, проходит симуляцию на ?песочнице? с учётом текущего состояния всех узлов. И самое главное — мы оставили за человеком право окончательного вердикта на критические операции. Система может предложить, но не исполнить без подтверждения. Иногда старый добрый человеческий глаз и опыт видят то, что не заложено в алгоритмы.

Ещё из неудач: попытка использовать единые, супер-навороченные коммутаторы для всех сегментов. Казалось логичным — один тип железа, единая логика управления. Но для цеха нужны были модели с усиленной защитой от пыли и вибрации, а для серверной — с большей плотностью портов. Пришлось признать, что унификация ради унификации ведёт к переплате и неоптимальным решениям. Теперь мы используем разные модели, но управляем ими из единого интерфейса — это и есть здоровая централизация.

К чему мы пришли? Гибрид как норма

Итак, что такое для нас сегодня централизованная система управления сетью? Это уже не догма, а прагматичный гибрид. Централизованно мы видим общую картину, управляем политиками безопасности, собираем агрегированные отчёты. Но логика принятия решений, обработка критичных событий и сбор высокочастотных данных максимально делегированы на периферию, ближе к оборудованию.

Такая архитектура родилась не из книг, а из шишек, набитых за годы работы с реальным оборудованием для термического напыления. Она позволяет и сохранить ?единое окно? для контроля, и не создавать узких мест, которые парализуют всё производство при сбое в одном месте. Это особенно важно для нашей деятельности, где цикл от исследования нового состава покрытия до его нанесения на серийное изделие должен быть непрерывным и управляемым.

Если кто-то сейчас задумывается о внедрении подобной системы, мой главный совет — начинайте не с выбора вендора или софта, а с глубокого аудита своих процессов. Поймите, какие данные действительно нужны для принятия решений, а что — просто информационный шум. Определите, где нужна автоматизация, а где необходим человеческий контроль. И помните, что идеальная централизованная система — это не та, что контролирует всё, а та, что даёт нужную информацию нужным людям в нужное время, при этом оставаясь незаметной и надёжной, как электричество в розетке. Всё остальное — инструменты, и они должны подчиняться этой цели.

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

Нанесение износостойких покрытий на тормозные диски

Нанесение износостойких покрытий на тормозные диски -

LBP100H – Сверхзвуковая система плазменного напыления

LBP100H – Сверхзвуковая система плазменного напыления -

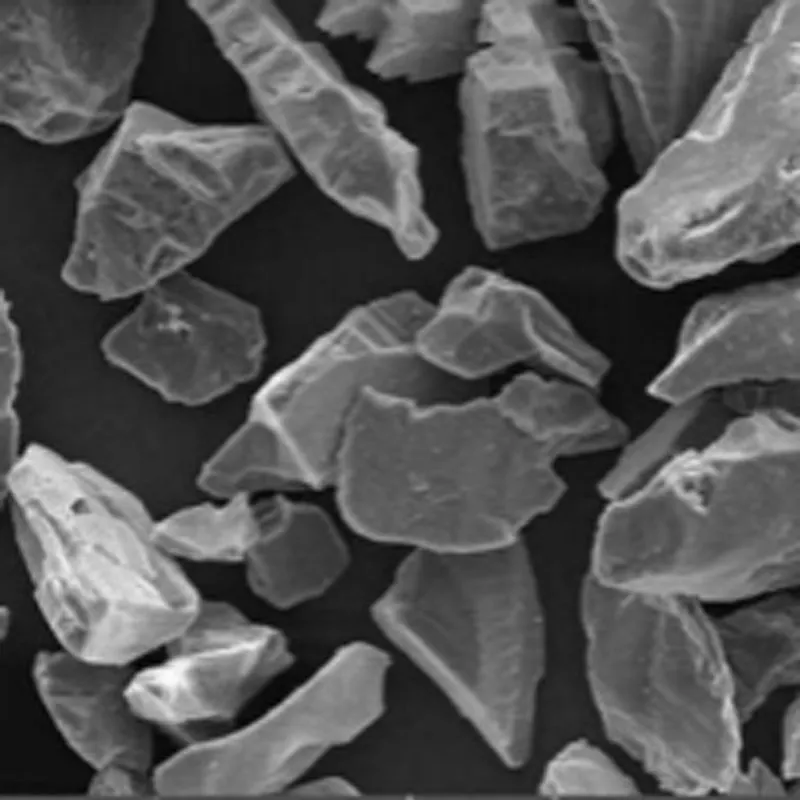

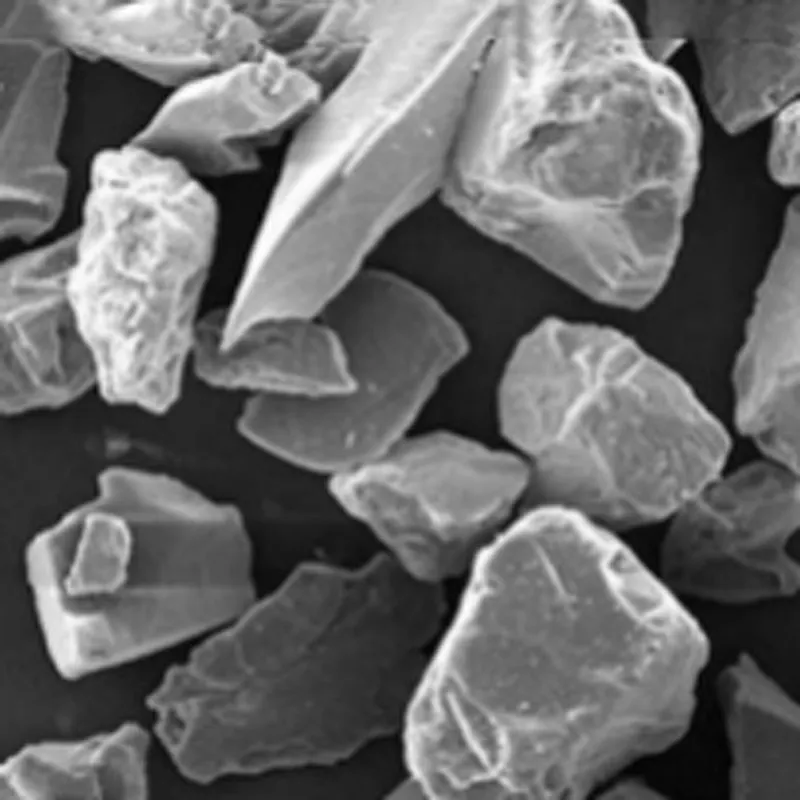

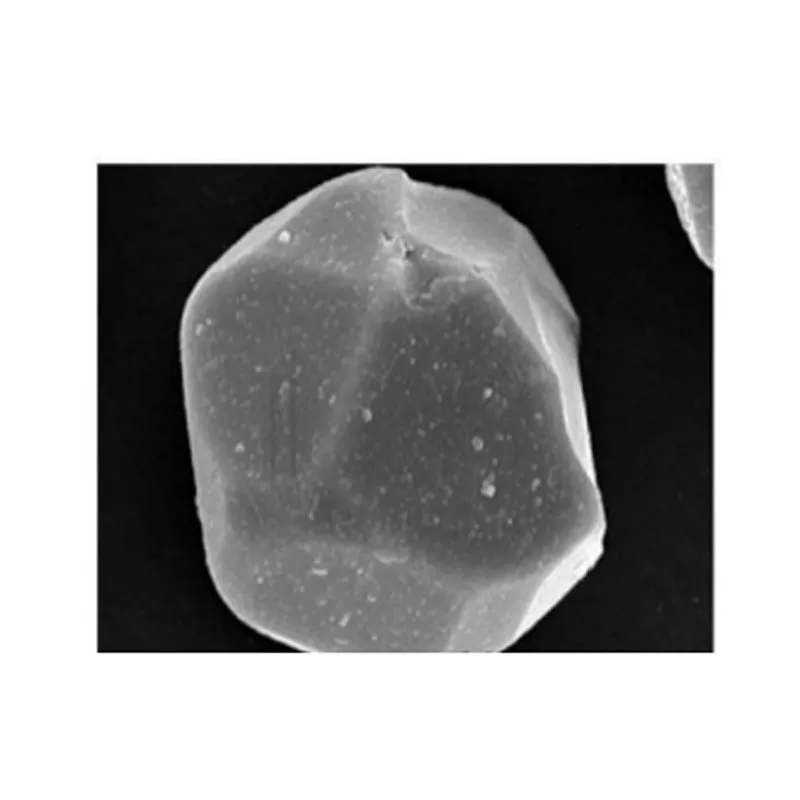

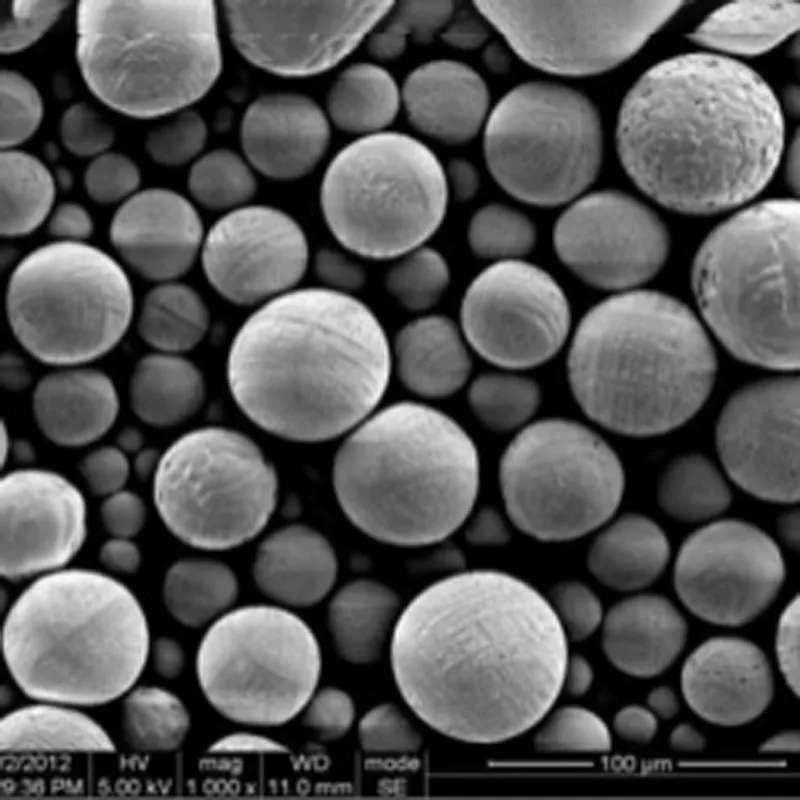

Серый алюмооксидный керамический порошок, 92% Al2O3

Серый алюмооксидный керамический порошок, 92% Al2O3 -

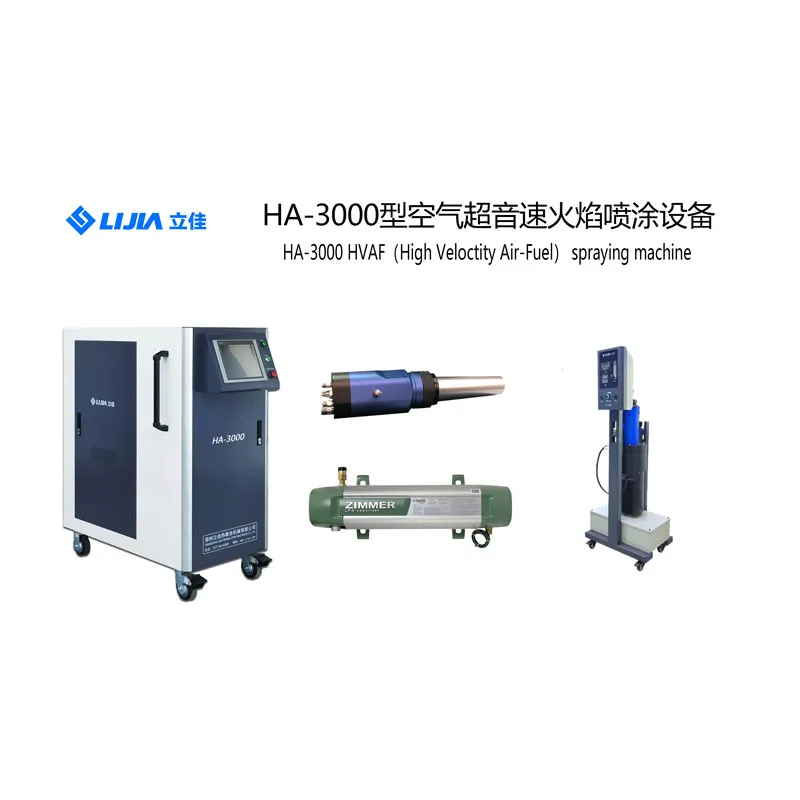

HA-3000 – Воздушная сверхзвуковая система газопламенного напыления

HA-3000 – Воздушная сверхзвуковая система газопламенного напыления -

Применение покрытий из карбида кремния

Применение покрытий из карбида кремния -

LBP-100 – Система атмосферного плазменного напыления

LBP-100 – Система атмосферного плазменного напыления -

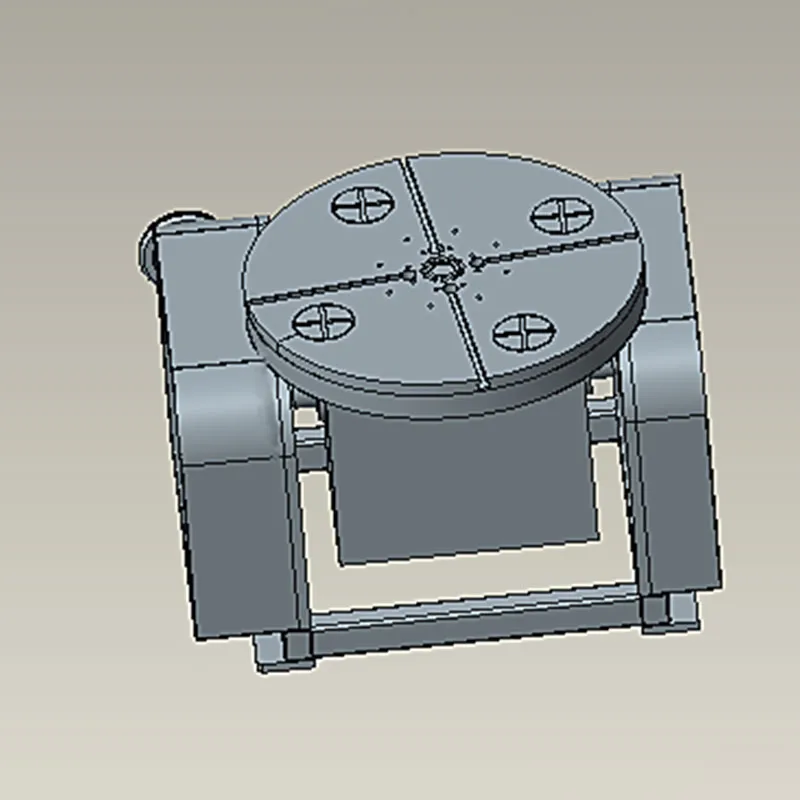

Вертикальная многоместная с регулируемым положением

Вертикальная многоместная с регулируемым положением -

Покрытие оксид хрома-40% оксида титана (Cr2O3-40% TiO₂)

Покрытие оксид хрома-40% оксида титана (Cr2O3-40% TiO₂) -

LH-3000 – Газовая сверхзвуковая система напыления

LH-3000 – Газовая сверхзвуковая система напыления -

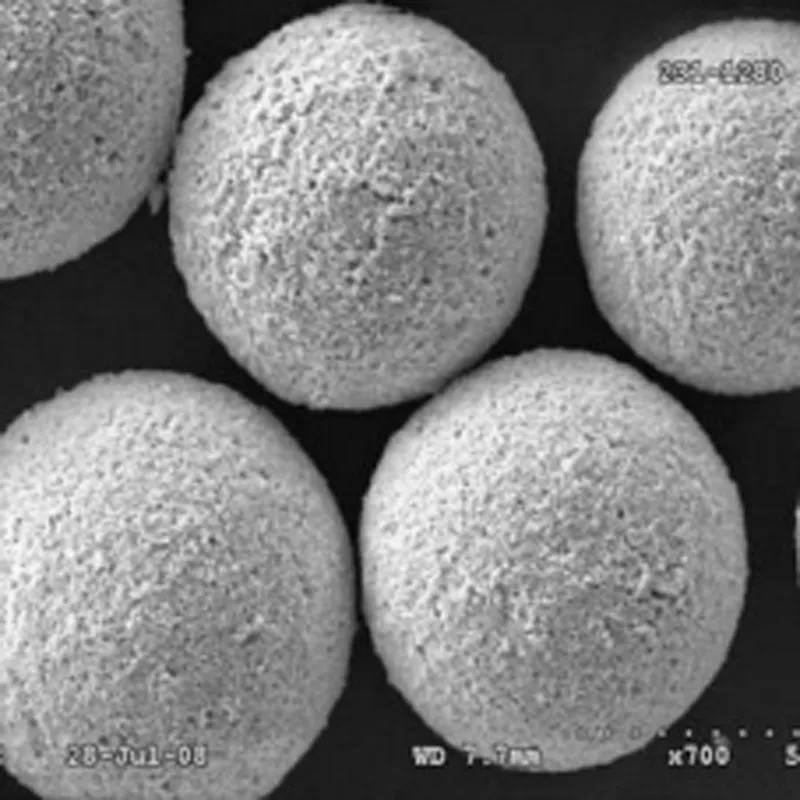

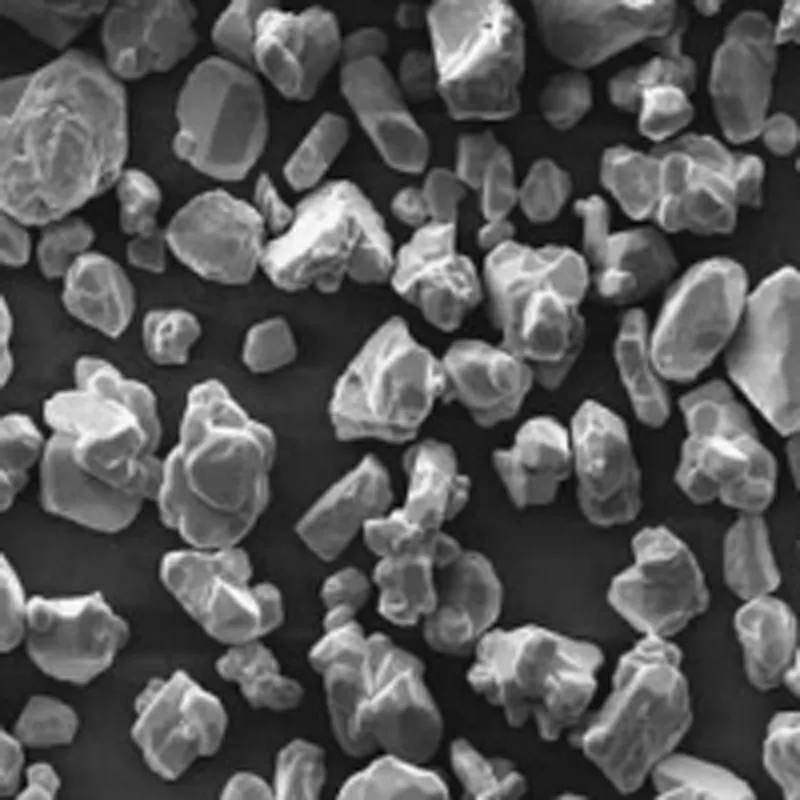

Керамическое порошковое покрытие на основе оксида хрома (Cr2O₃)

Керамическое порошковое покрытие на основе оксида хрома (Cr2O₃) -

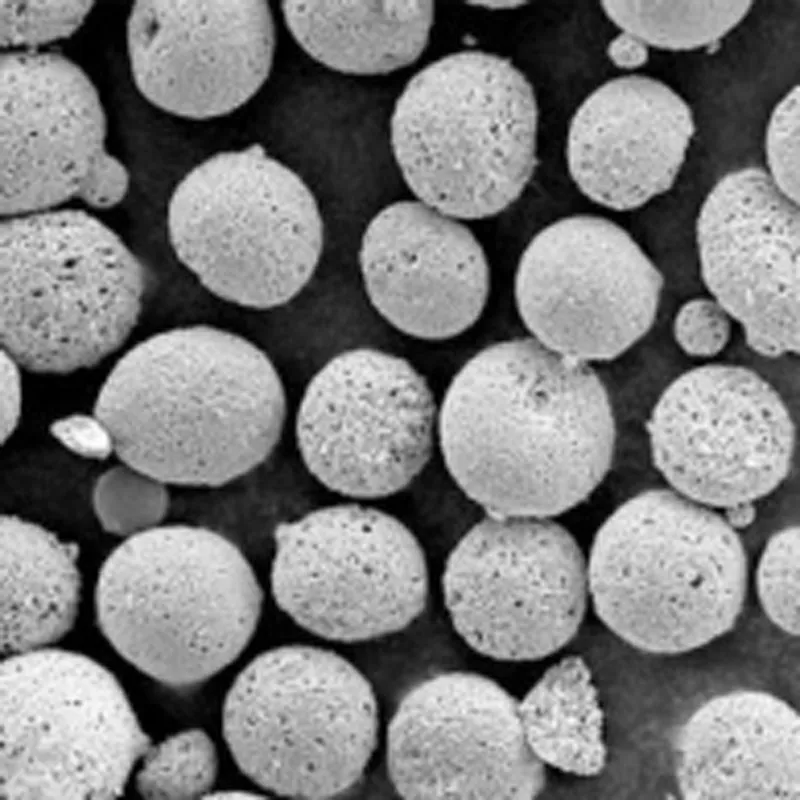

Керамический порошок оксида алюминия 99,99% (Al₂O₃)

Керамический порошок оксида алюминия 99,99% (Al₂O₃) -

Звукоизолированная окрасочная камера

Звукоизолированная окрасочная камера

Связанный поиск

Связанный поиск- ионно плазменное напыление

- HVAF для автомобильных деталей

- централизованная система управления для утилизации медицинских отходов

- дисковый питатель порошка

- вибрационный питатель порошка

- пылеуловитель для настольной пилы

- ручной поворотный стол для газотермического напыления

- какие бывают пылеуловители

- портативный манипулятор для нанесения покрытий

- питатели порошка